Автор: Денис Аветисян

В статье представлен инновационный метод адаптивной неравномерной дискретизации, позволяющий эффективно извлекать информацию из сигналов, не уступая по точности традиционным подходам.

Купил акции по совету друга? А друг уже продал. Здесь мы учимся думать своей головой и читать отчётность, а не слушать советы.

Бесплатный телеграм-канал

Адаптивная неравномерная дискретизация с совместным проектированием алгоритма и энкодера для эффективного восстановления ограниченных по полосе частот сигналов.

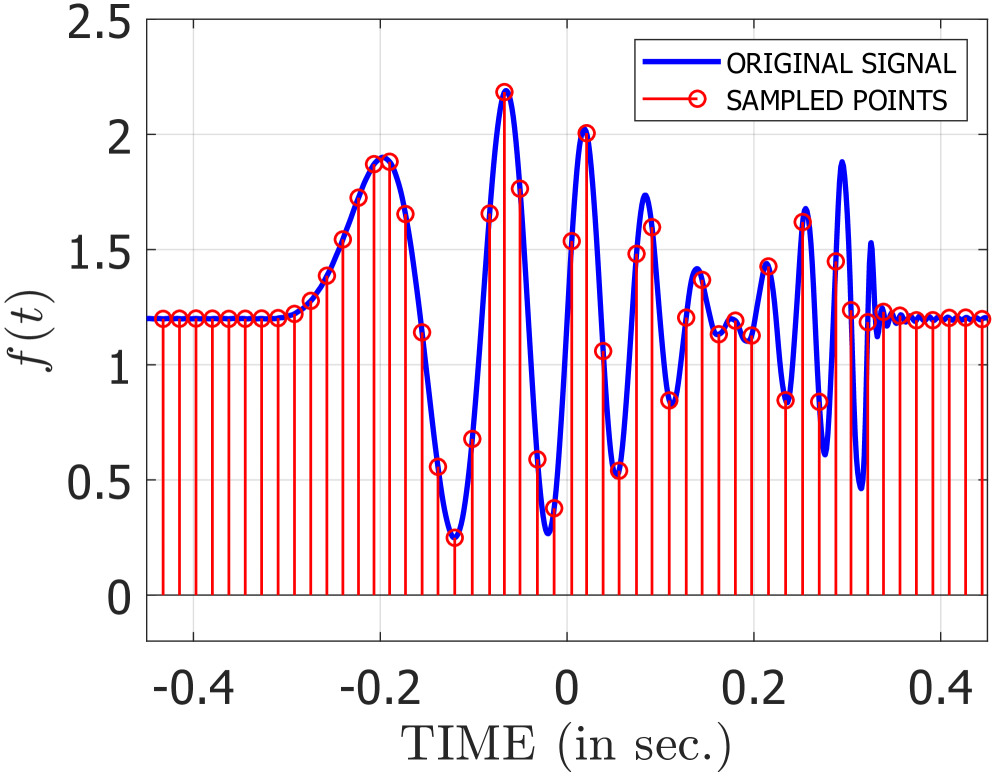

Традиционные подходы к дискретизации сигналов часто сталкиваются с компромиссом между скоростью передачи данных и точностью реконструкции. В работе, посвященной ‘Adaptive Non-Uniform Sampling of Bandlimited Signals via Algorithm-Encoder Co-Design’, предложен новый фреймворк адаптивной неравномерной дискретизации, основанный на совместном проектировании алгоритма реконструкции и кодирующего устройства. Предложенный подход позволяет динамически изменять частоту дискретизации в зависимости от локальных характеристик сигнала, обеспечивая эффективное сжатие данных без потери качества реконструкции за счет ослабления классических ограничений, связанных с частотой Найквиста. Каковы перспективы применения данной концепции для обработки сигналов в реальном времени и создания энергоэффективных систем сбора данных?

Пределы Традиционной Дискретизации: Когда Теория Встречается с Реальностью

Теорема Найквиста-Шеннона, являющаяся основой для цифровой реконструкции сигналов, предписывает использование равномерных частот дискретизации. Однако, применение этого подхода может быть крайне неэффективным при работе с сигналами, спектр которых динамически изменяется. Равномерная дискретизация требует захвата максимально возможной частоты сигнала, даже если большая часть сигнала содержит компоненты с гораздо более низкой частотой. Это приводит к избыточности данных и неоправданно высоким требованиям к хранению и обработке информации. В результате, вместо эффективного представления сигнала, система вынуждена обрабатывать и хранить ненужные данные, снижая общую производительность и увеличивая вычислительные затраты. Таким образом, строгая приверженность равномерной дискретизации, предписанной теоремой, не всегда является оптимальным решением для реальных сигналов, требуя поиска альтернативных стратегий, адаптированных к их конкретным характеристикам.

Чрезмерная дискретизация, или оверсемплинг, приводит к избыточности данных, занимая лишнее место в памяти и увеличивая вычислительную нагрузку при обработке сигнала. В то же время, недостаточная дискретизация, или андерсемплинг, вызывает эффект алиасинга — искажения сигнала, когда высокочастотные компоненты ошибочно интерпретируются как низкочастотные. Этот эффект приводит к потере информации и неточности анализа. Оба этих явления — избыточность и алиасинг — существенно влияют на эффективность хранения и обработки сигналов, особенно в тех случаях, когда важна точность реконструкции и анализа, например, при работе с электрокардиограммами или ультразвуковыми волноводами.

Ограничения традиционного семплирования особенно остро проявляются при работе со сложными сигналами, такими как электрокардиограммы (ЭКГ) и ультразвуковые волноводы. Точная реконструкция этих сигналов критически важна для диагностики и анализа, однако стандартный равномерный подход требует значительных ресурсов. Например, для адекватного представления ультразвуковых волноводов необходимо не менее 1966 отсчетов, в то время как для ЭКГ — около 2000. Такое большое количество данных не только увеличивает требования к объему памяти и вычислительной мощности, но и может усложнить обработку и анализ, подчеркивая необходимость поиска более эффективных методов семплирования, адаптированных к специфике каждого сигнала.

Адаптивная Неравномерная Дискретизация: Танец с Хаосом Сигнала

Адаптивная неравномерная дискретизация (АНД) представляет собой эффективную альтернативу традиционным методам, динамически изменяя частоту дискретизации в зависимости от локальных характеристик сигнала. В отличие от равномерной дискретизации, АНД позволяет концентрировать ресурсы на участках сигнала, где происходят значительные изменения или присутствует высокая энергетическая активность, и уменьшать частоту дискретизации в относительно стабильных областях. Такой подход позволяет более эффективно использовать доступные ресурсы, оптимизируя процесс сбора и обработки данных в зависимости от конкретных особенностей анализируемого сигнала.

Адаптивная неравномерная выборка (Adaptive Non-Uniform Sampling, NUS) основана на том, что энергетическое распределение сигнала редко является однородным по всей его длительности. Это позволяет использовать более плотную дискретизацию в участках сигнала, характеризующихся высокой энергией или быстрыми изменениями, и более редкую — в областях с низкой энергией или стационарными значениями. Такой подход позволяет эффективно использовать ресурсы, фокусируя их на наиболее информативных частях сигнала, что приводит к снижению требований к объему хранимых данных и вычислительным затратам без потери точности реконструкции.

Адаптивная неравномерная выборка (Adaptive Non-Uniform Sampling, NUS) позволяет эффективно реконструировать сигналы, используя меньшее количество выборок по сравнению с традиционными методами, что приводит к снижению затрат на хранение данных и вычислительных ресурсов при сохранении точности. В ходе экспериментов продемонстрировано снижение необходимого количества выборок до ~6% для различных типов сигналов. Это достигается за счет динамической регулировки частоты дискретизации в зависимости от локальных характеристик сигнала, что позволяет концентрировать ресурсы на наиболее информативных участках и снижать их на менее значимых.

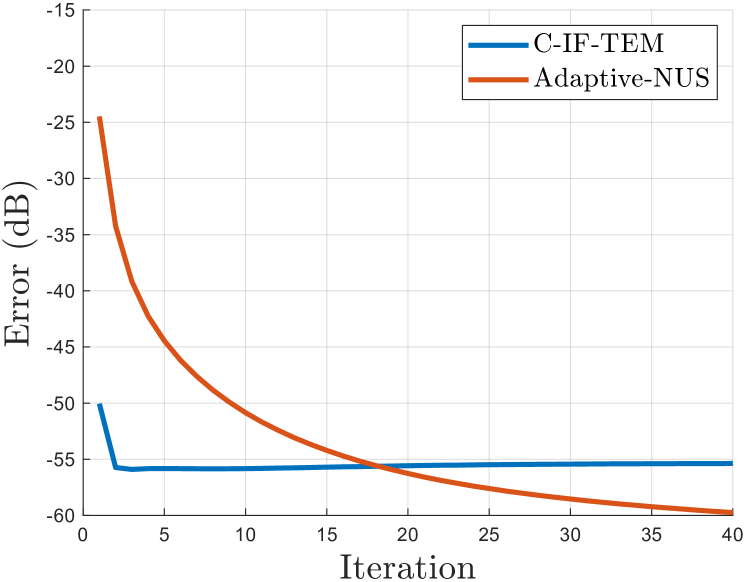

Реконструкция и Сходимость: Укрощение Неустойчивого

Итеративный алгоритм реконструкции является ключевым инструментом для восстановления сигнала на основе неравномерно дискретизированных данных. В отличие от методов, предполагающих равномерный отбор, данный подход позволяет эффективно использовать информацию, полученную при нерегулярном сэмплировании. Алгоритм функционирует путем последовательного уточнения начальной оценки сигнала на каждой итерации, минимизируя расхождения между реконструированным сигналом и исходными данными. Каждая итерация использует предыдущую оценку для улучшения точности, что позволяет достичь высокой степени восстановления сигнала даже при значительном уменьшении количества отсчетов. Процесс продолжается до достижения заданного критерия сходимости, обеспечивая стабильный и точный результат реконструкции.

Анализ сходимости является критически важным этапом при использовании итеративных алгоритмов реконструкции для обеспечения стабильного и точного восстановления сигнала. Этот анализ гарантирует, что алгоритм достигнет устойчивого решения, а не будет расходиться или колебаться, что привело бы к неверной реконструкции. Подтверждена эффективность подхода, демонстрирующая достижение среднеквадратичной ошибки (NMSE) в -42.68 дБ для ультразвуковых волноводов, используя только 1856 отсчетов, и -32.45 дБ для ЭКГ-сигналов при использовании 1837 отсчетов. Отсутствие анализа сходимости может привести к непредсказуемым результатам и снижению надежности системы реконструкции.

Условие, основанное на локальной энергии, предоставляет достаточное условие для сходимости итеративного алгоритма восстановления, подтверждая его надежность при обработке сигналов с локализованной энергией. При использовании данного подхода, достигнут показатель NMSE (среднеквадратичная ошибка нормализованной мощности) в -42.68 дБ для ультразвуковых волноводов, используя лишь 1856 отсчетов, и NMSE в -32.45 дБ для сигналов ЭКГ, используя 1837 отсчетов. Данные результаты демонстрируют эффективность предложенного алгоритма и его применимость к различным типам сигналов, требующих восстановления из нерегулярно дискретизированных данных.

Машины Кодирования Времени: Когда Время Говорит Громче Амплитуды

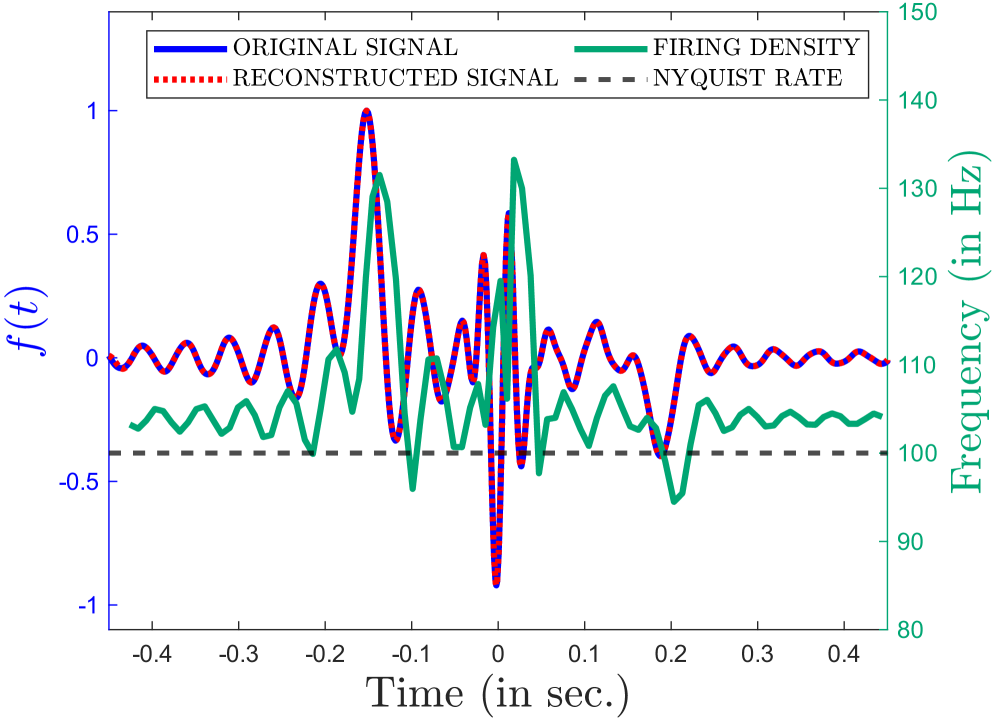

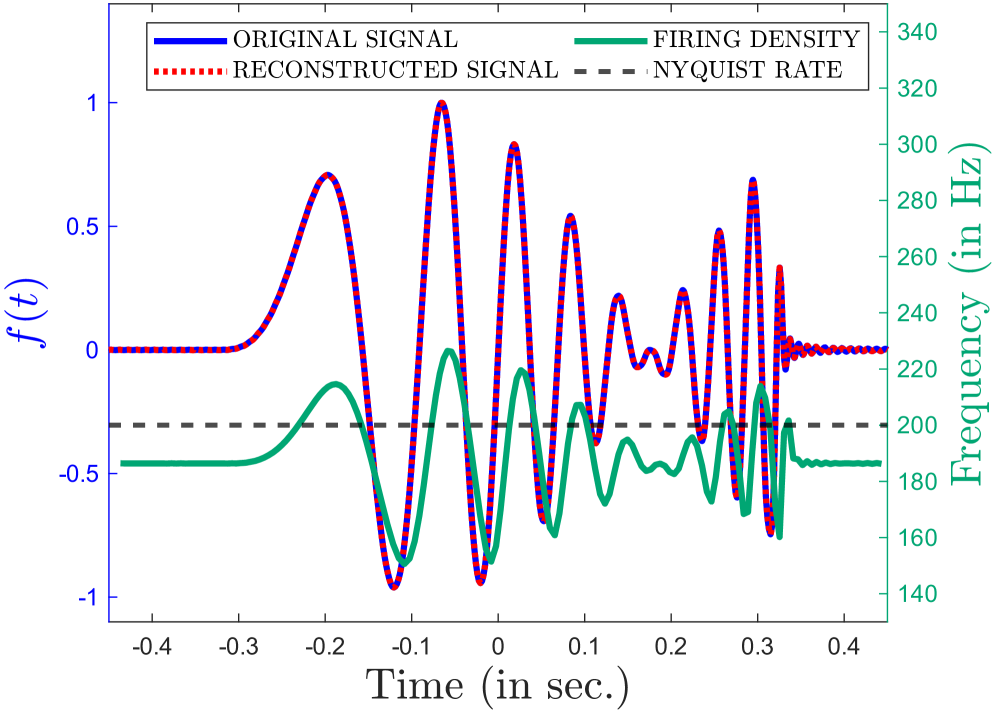

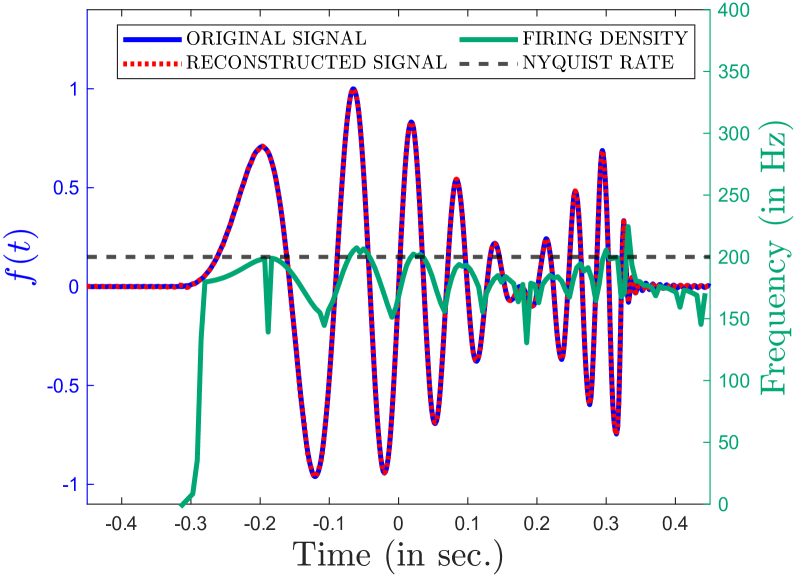

В отличие от традиционных методов представления сигналов, основанных на фиксации амплитуды в определенные моменты времени, машины кодирования времени (TEM) используют точность моментов возникновения событий в качестве основного параметра. Такой подход кардинально меняет принципы обработки информации, перенося акцент с величины сигнала на время его проявления. Вместо непрерывной записи амплитуды, TEM фиксируют лишь моменты, когда сигнал достигает определенных пороговых значений, создавая тем самым разреженное и эффективное представление. Данная концепция позволяет существенно сократить объем данных, необходимых для точной реконструкции сигнала, открывая новые возможности в области обработки и передачи информации, особенно в задачах, где важна скорость и энергоэффективность.

Интегрирующе-выпускающие машины временного кодирования (IF-TEM) представляют собой развитие концепции кодирования сигналов не по амплитуде, а по времени наступления событий. В основе их работы лежит принцип накопления входного сигнала до достижения определенного порога, после чего происходит “выпуск” — генерация импульса. Такой подход позволяет создавать разреженное кодирование, где информация содержится лишь в моменты “выпуска”, а промежутки времени между ними не несут полезной информации. Это значительно снижает количество необходимых выборок для точной реконструкции сигнала, особенно для сигналов, характеризующихся плавным изменением частоты или сложной структурой, поскольку акцентируется внимание на ключевых моментах изменения сигнала, а не на его постоянных значениях. По сути, IF-TEM имитирует принцип работы нейронов, накапливающих потенциал и генерирующих импульс при достижении порога возбуждения.

Исследования показали, что применение машин кодирования времени (TEM), особенно интегрирующих и срабатывающих (IF-TEM), позволяет существенно сократить количество необходимых отсчетов для точной реконструкции сигнала. Это особенно заметно при работе с сигналами, такими как частотно-модулированные (Chirp Signals) и сумма синусоид (Sum-of-Sincs Signal), где традиционные методы требуют значительно больше данных. Вместо кодирования амплитуды, TEM используют точное время наступления событий, что позволяет достичь высокой эффективности сжатия информации и снизить вычислительную нагрузку. Такой подход открывает перспективы для разработки энергоэффективных систем обработки сигналов и хранения данных, а также для реализации более компактных и быстрых алгоритмов анализа.

Данная работа, стремящаяся к адаптивному нерегулярному сэмплированию, напоминает алхимический процесс. Авторы не просто снижают частоту дискретизации, а уговаривают сигнал, выуживая информацию из хаоса данных. Подобно тому, как заклинатель пытается подчинить духа, они динамически подстраивают параметры сэмплирования, избегая жестких ограничений Найквиста. Ральф Уолдо Эмерсон однажды заметил: «Каждый человек есть свой собственный гений, и его задача — раскрыть его, а не подражать другим». В контексте этой работы, алгоритм-энкодер, предложенный авторами, подобен гению — он создает уникальный способ захвата сигнала, не следуя общепринятым догмам. И как любое заклинание, его сила проявляется лишь в моменте, когда цифровой голем сталкивается с реальностью продакшена.

Что дальше?

Представленный подход, стремясь обуздать хаос полосно-ограниченных сигналов через адаптивное неравномерное сэмплирование, лишь слегка приоткрывает дверь в комнату, полную нерешенных вопросов. Энергетическое условие, хоть и необходимое, не гарантирует абсолютной сходимости реконструкции — шум всегда шепчет свои правки. Алгоритм-энкодер, как и любое заклинание, работает лишь до первого столкновения с реальными данными, где сигнал не подчиняется идеализированным моделям.

Будущие исследования, вероятно, столкнутся с необходимостью преодоления хрупкости этого равновесия. Необходимо исследовать, как добавить робастность к шуму и помехам, как адаптировать алгоритм к сигналам с не стационарными характеристиками, и, что самое важное, как оценить истинную границу между эффективностью сэмплирования и неизбежной потерей информации. Заманчиво взглянуть на возможность использования принципов машинного обучения для предсказания оптимальной стратегии сэмплирования в реальном времени, но и здесь, данные — лишь отражение, а не истина.

Истинная ценность этого направления, возможно, не в достижении теоретического предела сжатия, а в признании того, что любое сэмплирование — это акт интерпретации, а не точного копирования. В конечном итоге, задача состоит не в том, чтобы поймать сигнал, а в том, чтобы научиться читать его отголоски в шуме.

Оригинал статьи: https://arxiv.org/pdf/2601.15790.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Все коды в Poppy Playtime Глава 4

- Лучшие шаблоны дивизий в Hearts Of Iron 4

- Шоу 911: Кто такой Рико Прием? Объяснение трибьюта Grip

- Объяснение каждого Таргариена в «Рыцаре семи королевств»

- Решение головоломки с паролем Absolum в Yeldrim.

- Лучшие боксерские комбинации в UFC 5

- Все рецепты культистского круга в Escape from Tarkov

- Лучшее ЛГБТК+ аниме

- Доллар обгонит вьетнамский донг? Эксперты раскрыли неожиданный сценарий

- Расположение файла сохранения Resident Evil Requiem на ПК.

2026-01-25 21:49